Crowdsourcing-based Virtual Commissioning of Dynamic Human-Robot Teams (CroViCo)

This project is partially funded by the

This project is partially funded by theGerman Research Foundation (Deutsche Forschungsgemeinschaft, DFG).

Abstract (deutsch)

In der aktuellen Forschung zur Mensch-Roboter-Kooperation (MRK) gewinnen dynamische Systeme

zunehmend an Raum. Mit diesen Systemen können sich die Team-Mitglieder an individuelle Entscheidungen

wechselseitig anpassen und ihre Arbeit fortlaufend koordinieren, statt einem starr festgelegten Ablaufplan

zu folgen. So können unterschiedliche Montagefolgen je nach Werkerpräferenz, aber auch Fehlerfälle oder

extern verursachte Unterbrechungen in MRK-Abläufen berücksichtigt werden. Will man Roboter-Kollegen

mit diesen Anpassungsfähigkeiten in Benchmarks bewerten und vergleichen, dann ist dazu folglich eine

umfängliche Betrachtung unterschiedlicher Arbeitsabläufe notwendig – nur so können möglicher Nutzen und

Einschränkungen dynamischer Koordinierungsverfahren in verschiedenen Situationen abgeschätzt werden,

die während der gemeinsamen Bearbeitung einer Aufgabe auftreten können. Die im Feld der Mensch

Roboter-Interaktion gebräuchlichen Nutzerstudien sind für diese Abdeckung in der Breite ungeeignet, da sie

mit einem erheblichen Zeit- und Kostenaufwand einhergehen. Dieser Aufwand ließe sich jedoch in Anlehnung

an Verfahren zur virtuellen Inbetriebnahme reduzieren, indem relevante Arbeitsabläufe automatisch

generiert und rein simulationsgestützt ausgewertet werden. Die Herausforderung bei der automatisierten

Erzeugung von kooperativen Abläufen einer Aufgabe liegt dabei in der Wiedergabe plausiblen menschlichen

Handlungsverhaltens in Handhabungsprozessen, das aufgrund seines Nicht-Determinismus schwierig

abzubilden ist. Insbesondere diese wissenschaftliche Lücke hinsichtlich geeigneter kognitiver Mensch

Modelle wird im Rahmen des Forschungsvorhabens adressiert: Dazu ist zunächst zu untersuchen, inwieweit

sich mittels Online-Crowdsourcing repräsentative Daten sammeln und zu stochastischen Modellen

menschlicher Entscheidungsprozesse generalisieren lassen, sodass diese als künstliche Intelligenz des

Menschen in der Simulation auf unterschiedliche Handhabungsaufgaben übertragbar sind. Davon ausgehend

ist das Ziel des Vorhabens die Schaffung eines automatisierten, simulationsbasierten Benchmark-Systems,

das mit verschiedenen MRK-Systemen kompatibel ist und die reproduzierbare Beurteilung ihres Potenzials

im Rahmen einer virtuellen Inbetriebnahme ermöglicht, die realistische dynamische Situationen am

Arbeitsplatz berücksichtigt.

In der aktuellen Forschung zur Mensch-Roboter-Kooperation (MRK) gewinnen dynamische Systeme

zunehmend an Raum. Mit diesen Systemen können sich die Team-Mitglieder an individuelle Entscheidungen

wechselseitig anpassen und ihre Arbeit fortlaufend koordinieren, statt einem starr festgelegten Ablaufplan

zu folgen. So können unterschiedliche Montagefolgen je nach Werkerpräferenz, aber auch Fehlerfälle oder

extern verursachte Unterbrechungen in MRK-Abläufen berücksichtigt werden. Will man Roboter-Kollegen

mit diesen Anpassungsfähigkeiten in Benchmarks bewerten und vergleichen, dann ist dazu folglich eine

umfängliche Betrachtung unterschiedlicher Arbeitsabläufe notwendig – nur so können möglicher Nutzen und

Einschränkungen dynamischer Koordinierungsverfahren in verschiedenen Situationen abgeschätzt werden,

die während der gemeinsamen Bearbeitung einer Aufgabe auftreten können. Die im Feld der Mensch

Roboter-Interaktion gebräuchlichen Nutzerstudien sind für diese Abdeckung in der Breite ungeeignet, da sie

mit einem erheblichen Zeit- und Kostenaufwand einhergehen. Dieser Aufwand ließe sich jedoch in Anlehnung

an Verfahren zur virtuellen Inbetriebnahme reduzieren, indem relevante Arbeitsabläufe automatisch

generiert und rein simulationsgestützt ausgewertet werden. Die Herausforderung bei der automatisierten

Erzeugung von kooperativen Abläufen einer Aufgabe liegt dabei in der Wiedergabe plausiblen menschlichen

Handlungsverhaltens in Handhabungsprozessen, das aufgrund seines Nicht-Determinismus schwierig

abzubilden ist. Insbesondere diese wissenschaftliche Lücke hinsichtlich geeigneter kognitiver Mensch

Modelle wird im Rahmen des Forschungsvorhabens adressiert: Dazu ist zunächst zu untersuchen, inwieweit

sich mittels Online-Crowdsourcing repräsentative Daten sammeln und zu stochastischen Modellen

menschlicher Entscheidungsprozesse generalisieren lassen, sodass diese als künstliche Intelligenz des

Menschen in der Simulation auf unterschiedliche Handhabungsaufgaben übertragbar sind. Davon ausgehend

ist das Ziel des Vorhabens die Schaffung eines automatisierten, simulationsbasierten Benchmark-Systems,

das mit verschiedenen MRK-Systemen kompatibel ist und die reproduzierbare Beurteilung ihres Potenzials

im Rahmen einer virtuellen Inbetriebnahme ermöglicht, die realistische dynamische Situationen am

Arbeitsplatz berücksichtigt.

Keywords: Robotik, Mensch-Roboter-Kooperation, Benchmarks

Abstract (english)

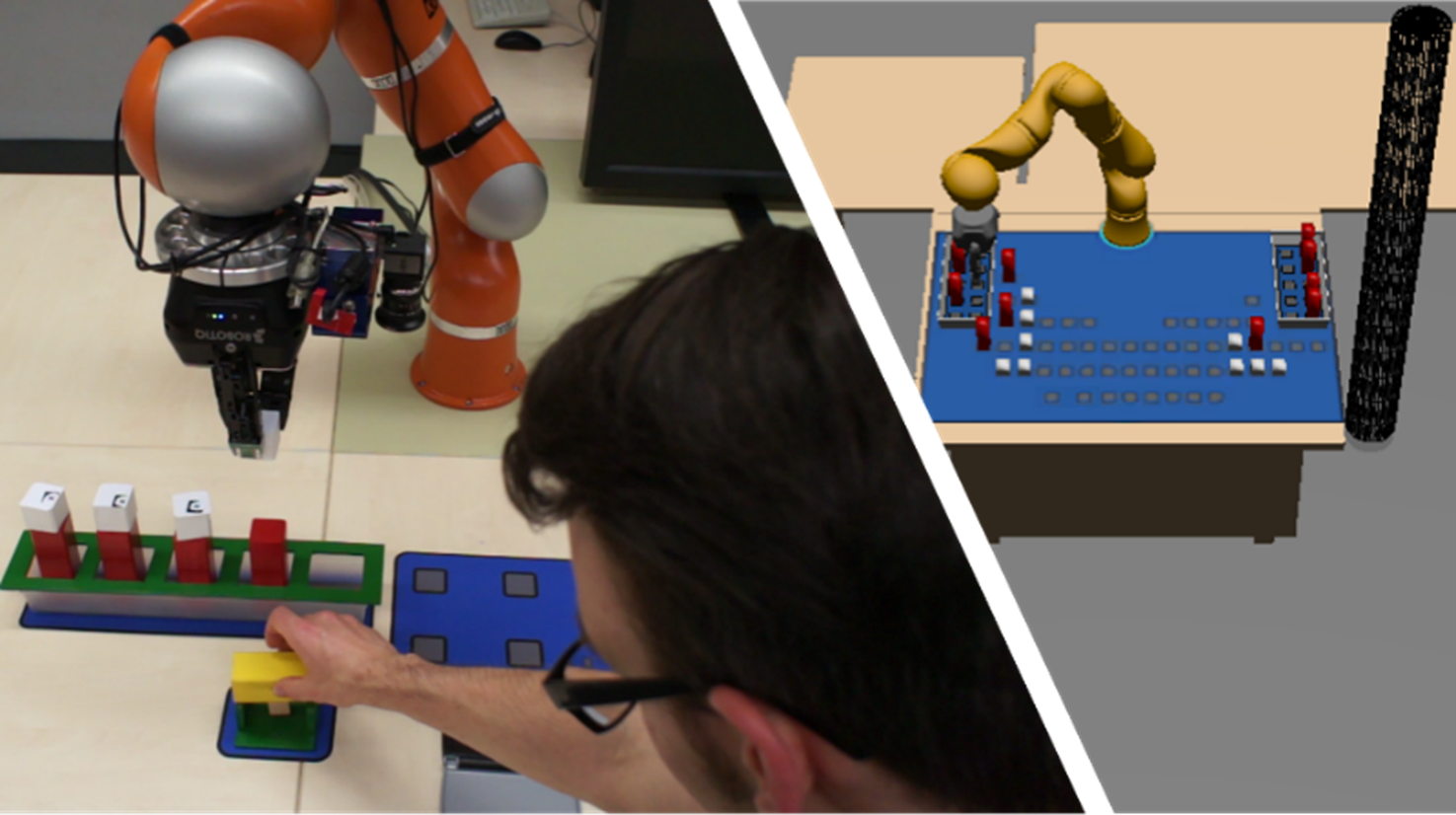

Recent research on human-robot task sharing has been putting emphasis on dynamic workflows. Respective

methods allow for mutual adaptation and continuous coordination of actions instead of following a fixed and

rigid shared plan. Hence, they support different product assembly sequences according to worker

preferences, handling of errors or interruptions because of external events. It is therefore necessary to

comprehensively consider various workflows that may emerge during joint task execution when seeking to

assess dynamic approaches. Benchmarking can only then provide profound insights into the benefits and

limitations of a dynamic cobot system when put into concrete application scenarios. User studies as

commonly used in the field of human-robot interaction are clearly too costly and time-consuming for this

purpose – we, consequently, envision a novel benchmarking approach that takes inspiration from virtual

commissioning techniques and simulates dynamic execution processes automatically. The challenge when

trying to generate such processes lies in the scalable simulation of realistic human working strategies in

cooperative handling processes. These are hard to foresee and model due to their indeterminism. In this

research project, we address this scientific gap regarding cognitive digital human models: We are seeking to

investigate the extent to which data on human decisions and actions can be gathered by online

crowdsourcing, and how respective data can be generalized by stochastic models of working strategies that

can be applied to different benchmark tasks as an artificial intelligence of simulated humans. From this point,

the long-term project goal is to establish a virtual commissioning framework with an interface that renders

automatic, reproducible performance measurements for numerous dynamic human-robot teaming methods

feasible.

Keywords: Robotics, Human-robot collaboration, Benchmarks